L’analyse de grandes quantités de données peut vous conduire à une grave erreur. Voici pourquoi, et comment vous en préserver.

Dans mon récent « quiz » parlant de technologie, j’ai mentionné que dénicher des données exploitables enfouies sous des montagnes de données inutiles, cette activité que l’on nomme dans la jargon « data-mining », constituait un parfait domaine d’application pour l’intelligence artificielle et en particulier pour les réseaux neuronaux.

Mais j’ai également mentionné que cette activité pouvait conduire à une énorme erreur, à un biais logique dont nous devons tous nous méfier. Ce biais, que l’on peut appeler sans surprise «le data-mining bias» (pas de traduction française correcte), est ce dont je souhaite parler aujourd’hui.

Parlons donc de cet effrayant biais !

Celui-ci, de part son nom anglais barbare et son lien sémantique avec l’informatique peut sembler quelque chose de très technique et qui ne peut donc concerner que les geeks. Mais ce n’est pas le cas du tout! C’est une erreur très commune à laquelle tout le monde est confronté régulièrement. Vous, moi, tout le monde.

Rappelons néanmoins que le processus d’exploration systématique de grandes quantités de données reste une méthode parfaitement valide qui consiste à extraire de ces données, à priori sans intérêt, des corrélations, des séries temporelles, des tendances, des similitudes… « Bien pratiqué », avec prudence et rigueur, cette méthode peut en effet conduire à des découvertes utiles.

Mais elle peut aussi conduire à une grosse erreur. Voici pourquoi.

Mais d’abord, illustrons-la.

Voici donc quelques exemples concrets pour illustrer ce problème et comprendre pourquoi vous devriez lire la fin de cet article !

Premier exemple: le sensationnalisme journalistique

Les journalistes ont besoin de nous faire peur, ils ont besoin de nous faire croire tous les jours que quelque chose mérite d’être imprimé. Parfois, c’est vrai, mais parfois ce n’est pas vrai du tout.

Et cela se remarque particulièrement lorsqu’ils relatent, à titre d’exemple parmi tant d’autres, des conditions météorologiques «extrêmes».

C’est en effet un sujet dans lequel ils sont très souvent les victimes plus ou moins consentantes du biais tant redouté. Pour faire les gros titres, ils creusent dans l’histoire ou la géographie jusqu’à ce qu’ils trouvent quelque chose à comparer avec les conditions météorologique actuelles et nous effrayer de la sorte : « Nous vivons un moment historique de froid intense et dangereux ». La preuve: « il n’a jamais fait aussi froid dans ce département un 17 novembre depuis 23 ans. Nous sommes tous condamnés! ».

Voilà un illustration parfaite du biais de « data-mining« . Si vous êtes journaliste arrêter de faire cela s’il vous plait. Arrêtez de creuser les données historiques ou géographiques jusqu’à trouver quelque chose qui pourrait rendre spectaculaire ce qui ne l’est pas. Il fait froid en hiver et chaud en été, c’est normal. Bien sûr il est clair que cela se produit plus souvent que la normale en raison du changement climatique, c’est vrai, mais un seul événement ne suffit pas à prouver quoi que ce soit à ce sujet, et alimenter la peur à ce sujet n’est pas sain.

Et ceci n’est bien sûr pas limité aux bulletins météorologiques. Cette erreur se retrouve sur d’autres sujets comme la croissance des taux de petite délinquance dans des quartiers étroits (« significatifs » d’une hausse générale du crime), des chiffres d’immigration depuis un pays particulier et sur une période courte, nombre d’attaques de requins sur une plage au plus haut depuis 20 ans… Tout ce qui peut effrayer le public par un chiffre clé est potentiellement sujet au biais.

Deuxième exemple: corrélations médicales étranges

On entend souvent parler d’«études médicales» qui «prouvent» que consommer un certain produit vous donne une forte chance de mourir dans d’horribles souffrances ou au contraire de devenir plus jeune et encore plus beau. Ces études, toujours très surprenantes, proviennent parfois de « chercheurs américains » (les meilleurs !), et exposent des relations étranges sur des sous-ensembles de données très spécifiques.

Pour être tout à fait honnête, car je ne suis pas complètement naïf, la plupart de ces études sont financées par des lobbys et bien qu’elles puissent effectivement trouver des données qui «prouvent» ce qu’elles veulent prouver, elles sont malhonnêtes car elles savent que cela ne prouve pas grand chose et se gardent bien de vous le dire.

Voici un exemple typique de ceci: comment le café peut vous faire vivre plus longtemps! ( en anglais ).

En voici un autre: il y a quelques jours, ma femme a essayé de me convaincre que je devais arrêter ma consommation d’une petite bière en rentrant le soir avant le diner. Mais ce qu’elle a trouvé en premier lien sur Google ne lui a pas du tout plu puisqu’elle est tombée sur à une campagne financée par un groupement de brasseurs relatant une étude qui «prouvait» que la bière était bonne pour la santé… ceci en suivant l’amélioration d’une caractéristique médicale bien particulière, dans un groupe ethnique bien particulier et sur une période bien particulière…

J’ai lâchement, avec hypocrisie, essayé d’utiliser cette « étude » pour valider mon vice, mais elle n’a pas été dupe. Elle a naturellement et intuitivement débusqué le biais de « data-mining » qui n’était pas si subtilement caché dans les résultats de l’étude. Je n’ai plus le droit à ma bière du soir.

Observez comment ces études se limitent à des échantillons très spécifiques… c’est ainsi que vous pouvez détecter ce biais, volontaire ou non. En limitant les échantillons et en les séparant en sous-ensembles se recoupant selon de nombreux critères, vous créer de nombreuses « observations » différentes sur les mêmes données et vous avez alors une très bonne probabilité de trouver ce que vous voulez trouver.

En faisant le tour d’une droite dans l’espace il y un moment ou vous pourrez dire que vu sous cet angle elle ressemble à un point. Cela n’en fera pas un point pour autant !

Troisième exemple: le test historique de stratégie d’investissement ou « backtesting »

Souvent, en essayant de concevoir une stratégie d’investissement, les analystes financiers utilisent les données de marché passées, que ce soit des données de prix ou fondamentales, et creusent ces données dans l’espoir de trouver la relation d’investissement la plus célèbre au monde:

« Si ceci se produit en un instant N, alors le prix de cette action sera à la hausse en N + 1, et je serais incroyablement riche à l’instant N + 2. »

Et ils trouvent toujours une telle relation. Toujours. Sur le papier. Ils recherchent tous la martingale de l’investissement (ne perdez pas votre temps et votre argent cette relation n’existe pas, l’investissement est difficile, ne devient jamais plus facile et exige beaucoup de travail et de patience).

Mais quand ils décident de tester cela dans la vraie vie (et je dois avouer que je l’ai fait!), cela ne fonctionne pas et ils perdent de l’argent (et j’en ai perdu, mais c’est ainsi qu’on apprend sur les marchés).

Très bien tout çà, mais au final c’est quoi ce biais ?

La méthode statistique dit de « data-mining » consiste à traiter automatiquement d’énormes quantités de données afin de dénicher des informations utiles et statistiquement significatives (ce qui est une notion mathématique bien définie).

Le biais de « data-mining » est l’erreur de croire que tout ce que vous trouvez pendant une recherche selon cette méthode est significatif (c’est-à-dire non uniquement du à la chance).

Car il faut bien comprendre la chose suivante: si vous avez assez de données, et si vous observez ces données de suffisamment de manières différentes (des « observations » ) vous trouverez toujours « quelque chose ». Ceci une vérité statistique, ce n’est pas une opinion. C’est mathématique.

Il y a toujours quelqu’un qui gagne au loto. Même si la distribution des tirages est absolument aléatoire, si vous essayez assez longtemps, ou si suffisamment de personnes jouent, un événement très improbable se produira: il y aura un gagnant au loto.

Prenons un autre exemple : cette vidéo illustre l’utilisation d’un « tableau de Galton ». Ce jeu scientifique classique est le meilleur moyen d’expérimenter visuellement la distribution normale, ou en langage plus classique « la théorie des grands nombres ».

Comme vous pouvez le voir, il y a toujours des billes qui tombent aux extrémités du plateau. C’est très improbable mais ça arrive à chaque fois car il y a tellement de billes qui tombent que c’est inévitable.

Le risque est le suivant : si vous regardez uniquement ces billes « extrêmes » sans regarder le reste, vous pourriez être tentés de penser : « cela ne peut pas être aléatoire, il y a quelque chose qui ne va pas avec la planche ».

La principale erreur du biais de « data-mining » est de croire ceci:

« Si c’est très improbable, mais se produit quand même, alors ce n’est pas aléatoire »

Un autre bon exemple serait le tour de la prophétie des livres de Nostradamus: si vous mettez toutes les lettres d’un livre dans une matrice carrée pour chaque page et que vous cherchez des mots dans toutes les directions, vous vous retrouverez avec un nombre colossal de mots parmi lesquels vous pourrez choisir.

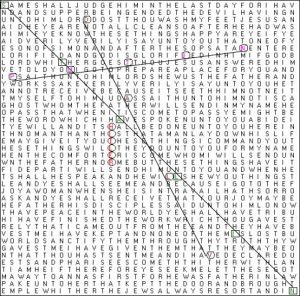

Voici un exemple ci-dessous:

Cette image prétend représenter une page de la Bible à l’intérieur de laquelle un conspirationniste particulièrement créatif (pas moi) aurait trouvé des noms « cachés ». Le fait que ces mots très apparentés soient disponibles sur la même page est certes extrêmement improbable, mais cela reste du pur hasard, ne vous y trompez pas.

Si vous prenez suffisamment de pages de livres et les analysez de cette façon (automatiquement, des logiciels existent pour cela), vous aurez de très bonnes chances d’arriver à un résultat similaire.

Si, au contraire, vous essayez de chercher un texte très spécifique sur une page, vous ne le trouverez très probablement jamais.

Le fait est que la notion de hasard est souvent mal comprise. En fait, un phénomène parfaitement aléatoire peut et doit sous certains angles paraitre très peu aléatoire. La meilleure illustration de ceci est cette expérience classique :

Si l’on vous demandait de créer artificiellement, sur le papier, le résultat d’une série «totalement aléatoire» de 1.000 tirages de pile ou face, vous auriez bien du mal à la faire ( tout comme moi ). En particulier il y a de fortes chances que votre série ne contienne pas assez de séries longues de tirages du même coté (par exemple 4, 5 ou 6 pile d’affilée), car cela ne vous paraîtrait « pas assez aléatoire ».

Mais cela arrivera en réalité. Statistiquement, si la série de tirage à pile ou face est vraiment aléatoire, des séries longues du même coté doivent se produire.

Ce biais est alimenté par 2 erreurs

Le biais de « data-mining » est en réalité très étroitement lié à deux autres biais cognitifs très importants dont vous devez être conscients:

1 – Confusion entre la corrélation et la causalité:

Deux séries de données qui sont corrélées ensemble dans un échantillon de données peuvent en fait n’avoir aucun lien réel entre elles. Les corrélations qui sont purement le résultat d’un bruit aléatoire dans les données ont un nom et sont ainsi appelées spurious correlation ou « correlation parasite » en français approximatif (encore une fois pas vraiment de traduction).

Mais être corrélé dans un série de donnée ne signifie pas qu’il y ait un lien réel, une « causalité », qui va donc se reproduire dans d’autres ensembles de données. Un lien qui dit et vérifiera à l’avenir : si « A monte, B va monter aussi ».

Pour quelque exemples amusant de ceci je vous conseille d’aller regarder rapidement ce site dédié au problème. Vous y apprendrez par exemple que le nombre de morts par jets de vapeurs et brulures par objet chaud au Etats-Unis (je l’invente pas) a ainsi été très fortement corrélé (87%) à l’age de Miss America entre 1999 et 2009…

2 – Le biais de confirmation est lui encore plus dérangeant, bien que largement répandu: il consiste à inconsciemment ( si c’est consciemment alors c’est de la malhonnêteté pure et non un biais ) rejeter toute preuve qui ne va pas dans le sens de notre opinion préconçue. Nous ne conservons alors que les arguments et preuves correspondants à ce que nous voulons trouver. Nous sommes naturellement poussés à confirmer notre opinion plutôt qu’à changer d’avis et par conséquent à creuser dans les données pour dénicher cette confirmation.

Pensez-y la prochaine fois que vous rechercherez sur Google quelque chose pour prouver à votre belle-mère que vous avez raison. Vous aurez une tendance naturelle à négliger les liens dont le titre ne correspond pas à votre opinion et à aller directement aux liens qui vous semblent « rationnels et sérieux ». Mais bon elle a tors non ?

Très bien, que puis-je faire pour éviter ce biais ?

Et bien d’abord, vous devez en être conscient. Cela devrait aller maintenant que vous avez lu cet article jusqu’à ce point. Mais n’oubliez pas ce concept à l’avenir.

Ensuite, vous devez rester extrêmement prudent dés lors que vous êtes face à une analyse basée sur un ensemble très large de données. Gardez à l’esprit que vous pouvez être dupé par d’autres autant que par vous-même!

Enfin, vous devriez toujours essayer de vérifier les résultats de ces études par la méthode qu’on appelle out-of-sample analysis ou « analyse hors-échantillon« . La logique de cette méthode est de rechercher des corrélations, des séries chronologiques, ainsi que tout type de relation qui pourrait avoir une valeur pour vous dans un ensemble précis de données, mais de toujours vérifier la validité des résultats dans un autre ensemble de données totalement séparé.

Pour les séries chronologiques, cela signifierait quelque chose comme «si je découvre que la croissance de la population de castors américains a augmenté parallèlement au nombre de voitures vendues au Japon entre 1980 et 1990, cette relation a elle persisté au cours des 10 années suivantes ?

Dans bien des cas cela prouvera qu’il n’y a en fait aucune relation entre ces deux phénomènes ( désolé de vous décevoir ), mais de temps en temps la relation sera confirmée, et là vous pourrez, avec prudence, commencer à tirer des conclusions intéressantes.

Une réflexion sur « Prenez garde au biais qui vous guette ! »